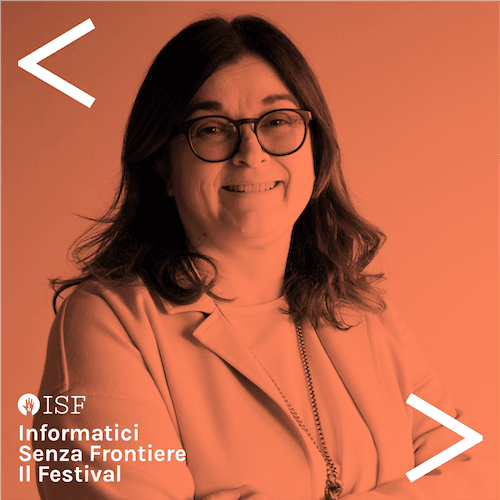

Perché dobbiamo avere un uso responsabile dell’intelligenza artificiale?

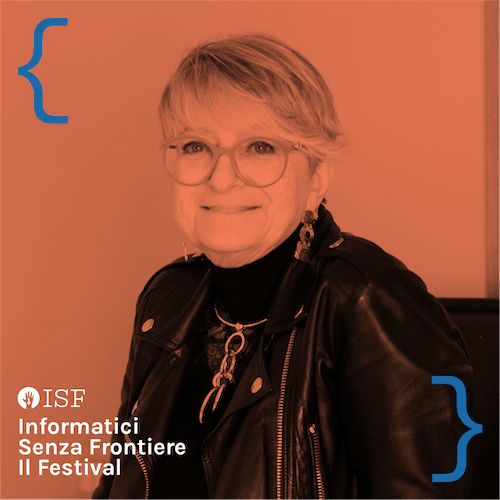

I sistemi di Intelligenza artificiale suggeriscono decisioni sulla base di pattern e regole imparate dai dati. I dati registrano l’esperienza passata e quindi contengono tutto il bene e tutto il male dell’esperienza. Incluso possibili bias e discriminazioni.

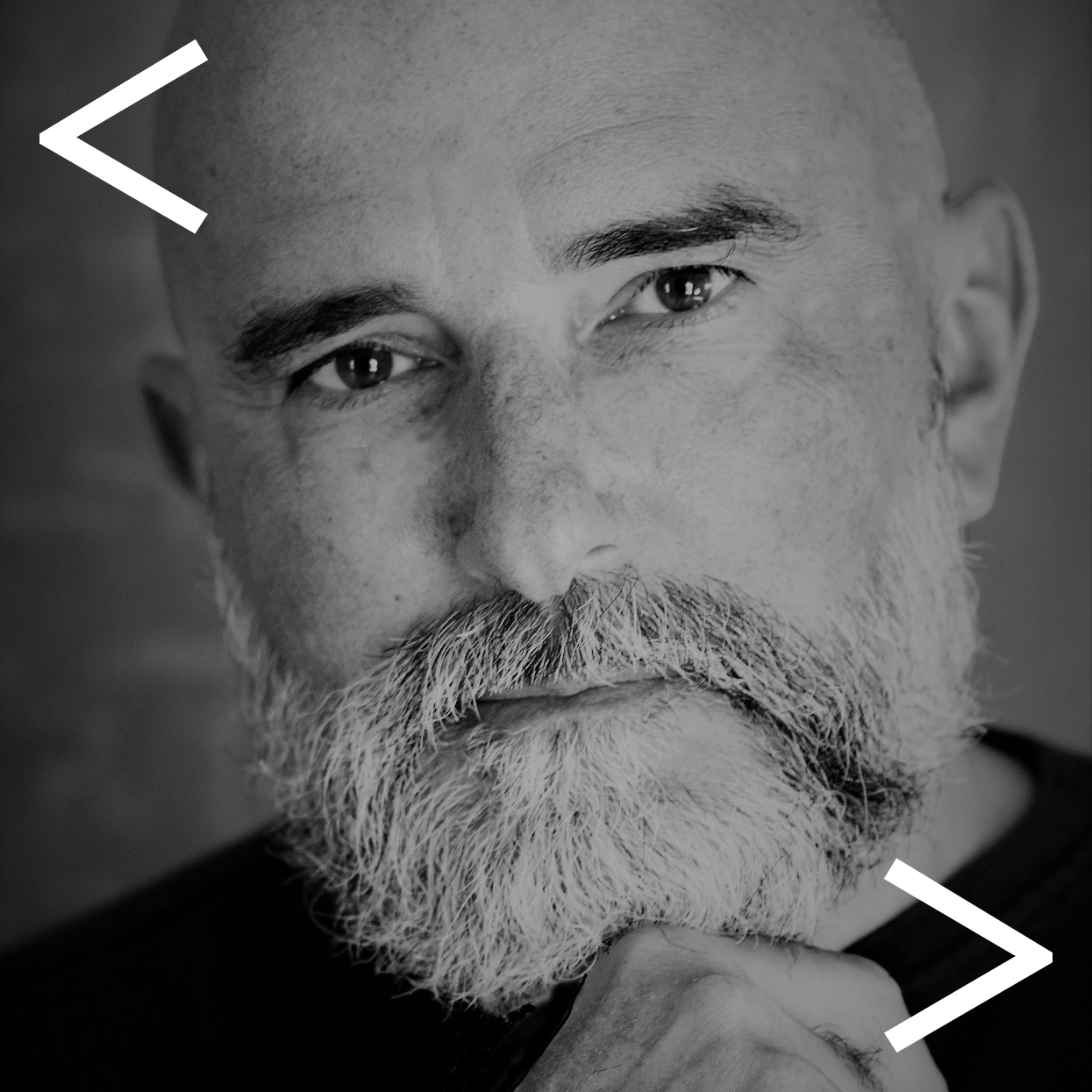

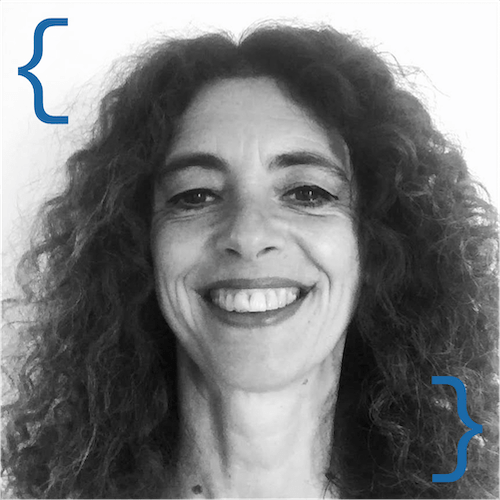

Per poter usare con fiducia e sicurezza questi strumenti per prendere decisioni importanti è necessario che questi non siano opachi ma siano in grado di proporre ai propri utilizzatori la spiegazione del loro funzionamento. Ecco perché si sta sviluppando così impetuosamente il settore di ricerca dell'”Explainable AI” per realizzare una corretta simbiosi tra persone e macchine in grado di aiutarci a prendere decisioni migliori preservando (ed espandendo) la nostra capacità cognitiva.

La conversazione illustrerà l’importanza e la difficoltà del tema mediante da una parte esempi che mettono a rischio tale simbiosi ed dall’altra la risposta della ricerca per costruire spiegazioni significative.

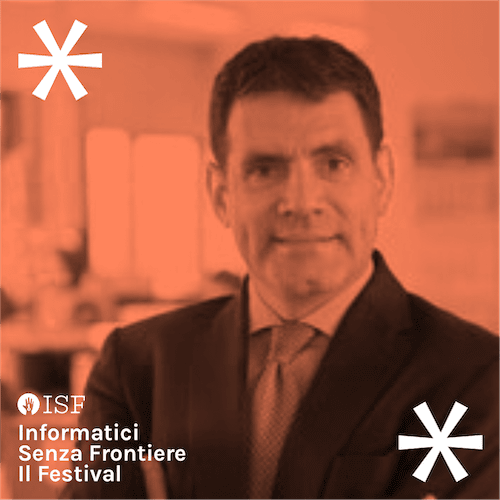

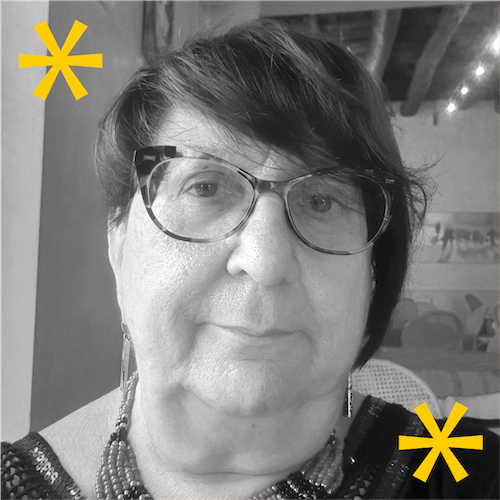

Il diritto alla spiegazione è uno degli elementi portanti per un uso responsabile dell’Intelligenza artificiale, l’intervento cercherà di illustrare lo stato del dibattito in corso in Europa sul tema e sulle linee guida che dovrebbero essere usate nello sviluppare sistemi di AI centrata sulle persone e rispettosa dei valori etici fondamentali.